はじめに

フューチャー技術ブログでは長らくご無沙汰しております。フューチャー株式会社の佐藤と申します。Strategic AI Group (SAIG) の一員として様々な先端技術の研究や社会実装に取り組んでおりますが、このところはもっぱら自然言語処理 (NLP) 畑出身の人たちに揉まれながら過ごしています。

2024年3月11日(月)〜3月15日(金)において神戸国際会議場にて開催されました言語処理学会第30回年次大会 (NLP2024) に参加しました。

当社はプラチナスポンサーとして SAIG の 4 名がオンサイトで参加し、スポンサーブースでの会社紹介及びポスター発表を行いました。「機密情報検知における生成AIを用いたデータ拡張」と題した我々のポスター発表について、詳しくは先日 SAIG 岸波さんが公開した技術ブログ記事「言語処理学会 (NLP2024) でポスター発表を行いました」をご覧ください。

言語処理学会とは

言語処理学会は NLP 分野における国内最大の学会で、毎年 3 月に開催されています。年次大会は今年でちょうど 30 回目となり、記念講演も行われていました。口頭発表は 4 会場に分かれ、それと並行して 3 会場×日に 3-4 交代するポスター発表、最終日にはワークショップと盛りだくさんの内容です。

今回の大会スローガンは「30年のプロンプトから未来を創造する」でした。プロンプトとある通り、ChatGPT はじめ LLM の隆盛によって自然言語処理はいま最もホットな分野といっても過言ではありません。参加者数は当日登録含まない一日目時点で 2045 名と、昨年以上の伸び幅を見せ 2000 の大台に乗りました。加えて発表件数、スポンサー数も史上最多であり、参加していて非常に活気を感じる学会でした。

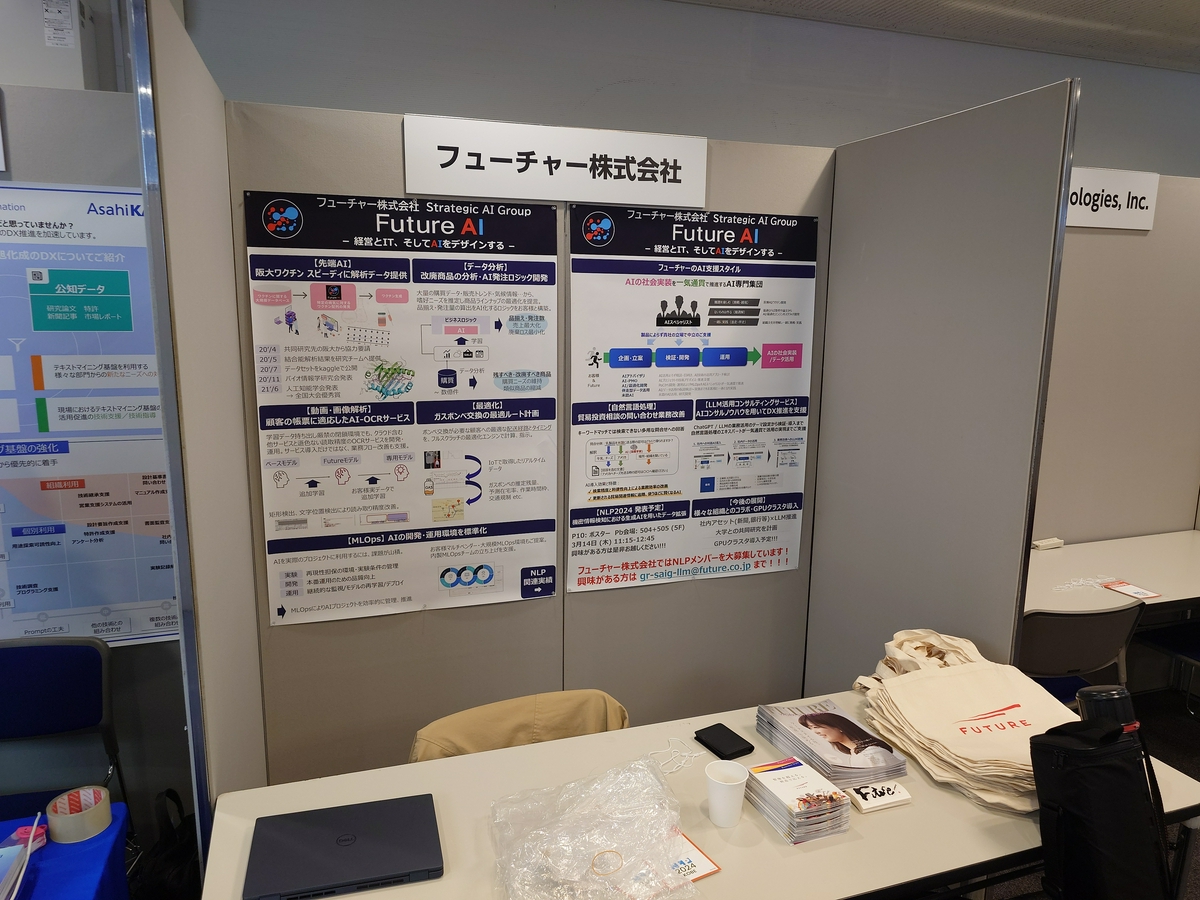

スポンサーブース

企業ブースを出展し AI 案件実績の紹介と人材募集を行いました。当社をご存じなかった方々にも数多くリーチでき、研究についてのディスカッションも盛り上がりました。

主に学生の方へ向けては、会社紹介のパンフレットと共にノベルティとしてトートバッグを配布しました。かなり多めに持っていったつもりでしたが、会期中ブースへ次々に足を運んでいただいたおかげでほぼほぼ売り切れました。

発表・セッションの紹介

このセクションでは、参加した各メンバーごとに口頭発表・ポスター発表の中からいくつか紹介します。

- [A1-2] プロンプトチューニングとkNN-LMを組み合わせたリスティング広告のタイトル自動生成

リスティング広告 (:=ググったときに画面の上に出てくるテキスト広告) のタイトル生成を題材に、言語モデル (LM)をファインチューニング (FT) することなく経時的な社会トレンド変化に追従させる方法を検討しています。筆者らは、LM の中間表現を事前に格納しておくことで FT なしにドメイン適応可能な kNN-LM と、prompting を行いより柔軟にトレンドに追従できる Instruction-Tuning 済の LM を組み合わせる方法を提案しました。さらに、これらのモデルを分割・変更しても性能の劣化が小さいことを示し、例えばある LM でシステムを構築した後により高性能な LM が公開された場合に、前者の中間表現をそのままに後者だけ更新してもよいのではないかと示唆しています。

実際の運用上定期的に FT を行うことは労力的に困難なことが多く、分割して一部だけ prompting を行えば性能が保持できそうという考察に惹かれました。発表における題材はリスティング広告という30字程度の生成でしたが、より長文の生成に対しても利用できれば楽しそうです。(佐藤) - [P8-6] 大規模言語モデル開発における日本語 Web 文書のフィルタリング手法の検証

日本語に適応した大規模言語モデル(LLM) のために日本語コーパスが求められる一方で、コーパスの大部分を占める Web コンテンツのフィルタリング手法が確立されていないことから、高速に処理できるフィルタリング処理方法を複数検討しています。ベンチマークの結果 N-gram LM の perplexity を元にした分類器の精度が最も良かったと評価できるものの、フィルタリングをかけても下流タスクの精度向上が有意にはみられず、また強すぎるフィルタリングによって下流タスク精度は大幅に悪化しました。フィルタリングによって特定トピックや特定ドメインのコンテンツ──端的に言うと楽天市場の商品名──が大きく減少していることや、perplexity が低くフィルタリングを通過しても日本語として支離滅裂な文章が存在することを観察しています。

直感的に低品質とわかる商品名等を除外できても精度向上に不足というのは難しいなと感じました。逆説的に、世の LLM が単純な N-gram 単位の perplexity によらない「文脈」を獲得していることの傍証とも言えそうです。(佐藤) - [B2-4] 対訳データを用いた継続事前訓練による大規模言語モデルの翻訳精度評価

この研究では、大規模言語モデル (LLM) の翻訳性能を高めるための手法として、対訳データを結合した文を用いる継続事前学習を提案しています。本研究の興味深い点は、はじめから大規模な翻訳データを指示学習のフォーマットに当てはめて学習する場合に比べて、継続事前学習の方式を取ることが極めて有効であったという点です。指示学習形式のfine-tuning (SFT) は指示文という羅針盤の存在により、空白から次のトークンを予測する (継続) 事前学習よりもはるかに小さな学習データから精度の向上を見込むことができる手法です。

今回、大規模な学習データを用意できる設定で指示学習 < 継続事前学習 (+指示学習) という構図が示されたことは非常に面白いと感じます。この研究では翻訳を題材としていますが、input-outputペアの結合による継続事前学習の他のタスクにおける有効性や、指示学習のスケーラビリティーに関する示唆が得られれば、LLMに関する理解を一歩深める良い研究になると思いました。 (藤井) - [B9-4] タスク指向型対話システムへの項目反応理論の適用によるユーザのタスク達成能力の推定

この研究では、タスク指向対話システムにおけるユーザのタスク遂行能力を項目反応理論 (IRT) に基づいて推定しています。項目反応理論 (IRT) は教育分野で用いられる考え方で、テストのある設問に対する多数の受験者の正誤データから設問の特性 (難しさや受験者の能力を判別する識別力) を分析し、各設問に対する解答パターンから尤もらしい受験者の能力を推定する、というものです。本研究では旅行案内タスクのデータセットを用いて、例えば「ホテルの予約に関する予算の希望を聞く質問に正しく予算を回答できるか?」といった質問をテストにおける1つの設問になぞらえることでIRTを適用しています。実験の結果、提案手法でユーザの能力を推定した場合、後続の対話におけるタスク遂行能力を比較的高精度で予測できることが示されています。

なお、実応用に際しては、事前に識別力の高い質問 (≒ ユーザの能力に応じて解答に大きくブレが生じるような質問) を一度は聞かなれけばならない、推定したユーザ能力に基づいて最短のターン数で目的を達成する対話に最適化する方法は自明でない等、残り越えるべき課題も残されています。しかしながら、システムが対話を通じてユーザに適応していくという考え方は非常に興味深く、今後の進展に期待できると考えます。 (藤井) - [P8-8] 日本語タスクにおけるLLMを用いた疑似学習データ生成の検討

近年、大規模言語モデル (LLM) にタスクの説明文と少数の事例を入力するFew-Shot等の手法が様々なタスクで高い性能を発揮することが知られていますが、GPUリソースの制約等、LLMの運用コストは高いです。この研究では、6つの日本語の自然言語処理タスクに関して、LLMを用いて疑似データを作成し、そのデータを用いてBERTのような小規模モデルを学習することで、LLMのFew-Shot等の性能にどの程度迫れるかを検証しています。各タスクの疑似データを作成するために、タスクの知識を利用したKADGという疑似データ生成手法を提案しています。提案手法はシンプルで、疑似データを生成する際のプロンプトにタスクに関する内容語を含めるというものです。提案手法によって疑似データを作成し、小規模モデルを学習させた結果、フォーマルなテキストを入力とするタスクでLLMの性能を上回ることを明らかにしました。

生成AIブームの中で、様々な場面でLLMが使用されがちですが、タスクによっては小規模モデルで十分と感じるケースもあります。そんななかで、学習データの作成にLLMを活用することで、小規模モデルでもLLMを超えられる可能性を示しているのは興味深いと感じました。また、今回の言語処理学会で我々もLLMを用いたデータ拡張の研究を発表しており、このような方向性の研究が発展していってほしいという期待も込めて挙げさせていただきました。 (岸波)

おわりに

大学院時代から実に 5 年ぶりのオフライン学会参加でした。奇跡的に、その 5 年前にも神戸のポートアイランドで発表をした覚えがあります。

NLP2024 は当時の研究分野から垣根を 2 つほど超えた先の分野ではありましたが、数多くの研究を見ることができとても良い刺激になりました。

現在 SAIG ではともに働くメンバーを募集しています。特に NLP分野における社会実装のニーズは根強く、多くの仲間を必要としているところです。キャリア採用ページでは シニアNLPエンジニアの募集 がピックアップされております。採用ページができておらず恐縮ですが、NLPリサーチエンジニア及びNLPエンジニアも同じく絶賛募集中です。条件等応相談ですので、我こそはという読者の方、是非先のリンクよりご応募をお待ちしております。

ほかにも幅広く 新卒採用 および キャリア採用 を募集中です。興味のある方は是非一緒に働きましょう。よろしくお願いします!

▲ 会場近くの南公園の噴水。

▲ 会場近くの南公園の噴水。