Go 1.26のリリースの足音が聞こえてきたので1.26の新機能のうち、気になる機能を有志で紹介していく連載です。

1.26の新機能のダイジェスト

久々に結構大きめな変更が多くなっていますね。

- new(プリミティブ)

- 1.25で導入されたGCが有効化

- cgo, memory allocate高速化

- goroutine leak profiler

- compilerがスライスをよりスタックに割り当てられるように

- SIMDを扱う実験的パッケージ(AMD64のみサポート)

- runtime/secretという機密情報を扱う実験的パッケージ

- image/jpeg が高速に

- io.ReadAllの消費メモリが少なく

- log/slogで複数の出力先に一気に出力できるMultiHandlerが追加

- testing.ArtifactDir

- 暗号アルゴリズムの更新たくさん

全体的に高速化が行われています。なのでアップデートするだけで恩恵がいろいろあります。

テストのArtifactDir()は-artifactsフラグを付けてテストを実行すると、T.ArtifactDir()メソッドが中間生成物の置き場を用意してくれて、そこに格納することであとから検死できるようになるというものです。以前、TempDir()が使いにくいというのを技術ブログで書きましたが、それのソリューションが提供された感じですね。

SIMD

それでは、今回追加されたsimd/archsimdパッケージについて紹介します。

1/29追記: まだ実験的機能で、コンパイル時にGOEXPERIMENT=simdという環境変数の設定が必要です。

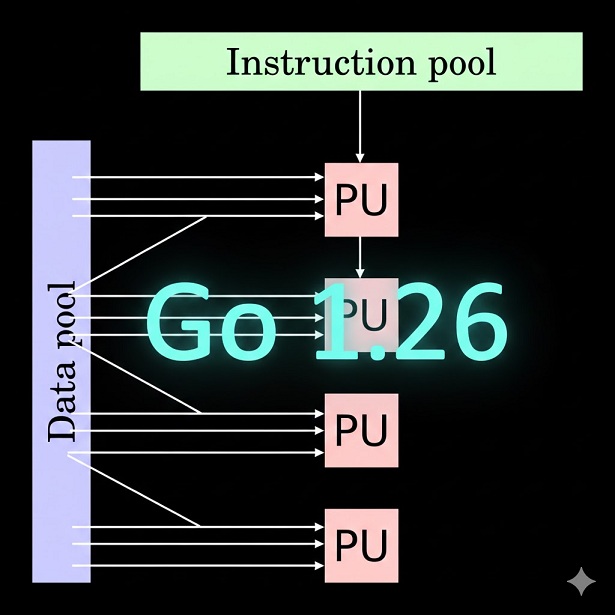

SIMDというのは1つの命令で複数のデータをまとめて処理する命令セットです。4つ、8つ・・・のデータをまとめて足し算したり、掛け算したり。行列計算などを高速に行うのに使います。

インテル系では主に以下のようにSIMDの命令セットの世代があります。それぞれとレジスタサイズの対応は以下の通りです。

- MMX: 64ビット

- SSE: 128ビット

- AVX: 256ビット

- AVX512: 512ビット

なお、AVX512はそれほど大量のデータを処理する必要とするアプリケーションが一部に限られるせいか、10th/11th Gen Core CPUでは対応していましたが、その後のチップからは取り除かれてしまいました。それだけ半導体を使うのに使用されないのであればその分通常のコア数を増やそうという感じですね。Eコア・Pコアに分かれた時代からは使えなくなりました。あとはCPUだけが早くてもメモリ転送がボトルネックになりそうですしね。

など、上記の命令セットの名前はインテルですが、AMD、ARM(NEON)なども備えています。

例えば、AVXは256ビットですが、これを8ビットx32本と使ったり、16ビットx16本として使ったり色々できます。simd/archsimdパッケージを見ると、いろんな型がありますが、よく見ると、Float32x8といった型になっております。たくさんありますが、データ型と要素数の組み合わせになっております。合計のビット数は128ビット、256ビット、512ビットであることがわかります。だいたい、和だったり、どのような演算をするかはメソッドで提供されていますが、int8/uint8などは和はあるが積などはないなど、型によって使えるメソッドに違いがあります。

なお、Goがバイナリを最後に生成するのに使うアセンブラは、アーキテクチャ限定でSIMD命令にはいくつか対応していたので、コードを .go ではなく、 .s で作成すればSIMDは今までも活用できました。Go 1.24で導入されたmapの新アルゴリズムのSwiss Tableは、SIMDを活用して高速検索するというものでした。サードパーティのライブラリでSIMDを使った行列演算ライブラリなどもいくつかありましたが、それが今回公式でできるようになりました。

ベクトルの内積計算

データ作成は後で説明するのですが、embedding化で作ったドキュメントのベクトルデータと、検索用語のベクトルデータの内積を取ることで、どれだけそれぞれの内容が近いかを数値化できます。ベクトル化すると、例えば「猫」について説明した文章があったとして、猫に近い「動物」や「トラ」といった言葉では距離が近いと判定されます。それにより、類似文書検索ができます。転置インデックスを使った全文検索だと「猫」で検索しないとヒットしませんが、ベクトル検索では近い内容も探せます。その分、ベクトルを計算するコーパスの質が大事で、今まではなかなか自由に簡単に使えるものがなかったのですが、生成AIのおかげでモデルを簡単にインストールしたり利用できるようになったので、簡単にベクトル検索ができる時代になりました。

まず、ollamaをインストールして、今回のembeddingで使うモデルを使えるようにしてローカルサーバーを起動しておきます。

ollama pull nomic-embed-text |

今回実験で使ったnomic-embed-textという軽量なモデルを使うと、768次元のベクトルとしてベクトルが計算できます。SIMDがなかったら、ループを回してそれぞれの項の積をしてから和を計算します。SIMDを使う場合、128ビットだと16ビットの要素の積を8つ同時に行えますし、内積用のメソッドを使うと和も求められます。

ベンチマークを取ってみると、6.6倍ほど高速になっていることがわかります。効果バツグンですね。なお、AMD64しか対応していないので、M3のMacBook AirでAMD64ビルドしたものをRosetta2でテストしています。そのうち早くネイティブ対応して欲しいですね。

なお、Rosettaのエミュレーションが公式には128ビットまでということでその範囲のテストになっていますが、非公式に256ビットとかも行けます。ただ、実行してみると128ビットの2倍程度の時間がかかっているので128ビット演算器で256ビットのエミュレーションをしている感じでしょうか?

% GOARCH=amd64 GOEXPERIMENT=simd go test -bench . -benchmem |

以下のコードがテストです。データの読み込みは省略しています。SIMDの方は[8]int16などの固定長配列を前提としているので、[][8]int16という形で、ベクトルを計算単位でまとめた二重配列的な構造にしてから与えています。なお、テストデータはReal World HTTPの原稿で、「クッキーのセキュリティ」という検索用語をそれぞれベクトル化してあらかじめファイルにしてあり、それを利用しています。

package main |

ベクトルの作成

ローカルでollamaを動かして、それにファイルを投げてベクトル化をします。なお、ベクトル化する場合はあまり長すぎるデータを与えてもコンテキストから溢れてエラーになってしまうため、あらかじめ原稿データを小さい単位の.rstファイルに分割しておきました。だいたい節タイトルごとに10行とか20行以下ぐらいに区切り、節タイトルがファイル名となるように事前処理しました。

積をSIMDでやるために計算はint16でやっていますが、データ自体は8ビットのベクトルとしていました。このあたり、どのあたりが良いのかはチューニングしていきたいですね。

package main |

検索の方のプログラムは全文を載せませんが、すでに載せているロジックの組み合わせでいきます。検索用語の方も上記のベクトル化と同じようにベクトル化を行います。そして、[][8]int16にすべてベクトルを変換しておき、あとはドット積の大きい順序でソートして返すだけです。

1/29追記: コンパイラの内部処理

ドキュメントを見ると、それぞれのメソッドに該当するCPU命令が書かれています。インテルのC言語のリファレンスもほぼ同じなのですが、1つの関数が1つのアセンブラ命令に該当します。このような関数をIntrinsicsと呼びます。Goの処理系でも、runtimeやsyncパッケージなどを中心に以前からこのようなintrinsicsな関数が多数存在していました。今回のSIMDのメソッドも同様の手法で実装されています。Go 1.7の時代にSSA形式が導入されましたが、それの結果、このような最適化も実装できるようになったようですね。

まとめ

AI界隈でよくでてくる計算がGoでも簡単に実現できるようになりました。類似検索とかベクトルデータベースの実装が今後増えることを期待しています。対応アーキテクチャも今後増えていくでしょう。WASMも対応になると嬉しいですね。

明日は武田さんになります。